- Ameya360 Component Supply Platform >

- Trade news >

- 谷歌开放TPU芯片,每小时6.5美元

谷歌开放TPU芯片,每小时6.5美元

谷歌TPU首次对外全面开放

谷歌在一篇博客文章中正式宣布,将以“有限数量”向谷歌云客户开放张量处理器(Tensor Processing Unit,简称TPU)服务。

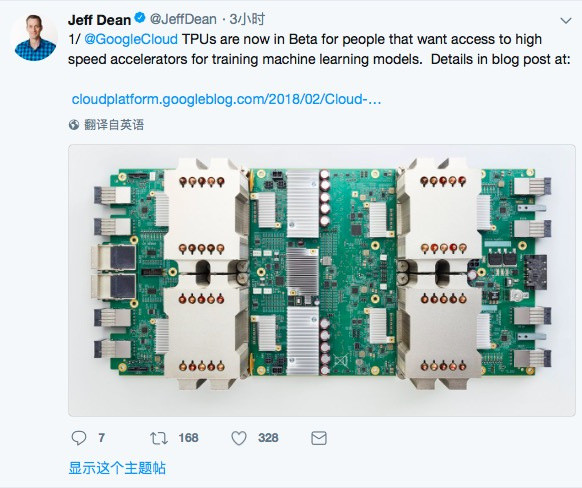

谷歌传奇工程师 Jeff Dean在推特上宣布谷歌TPU首次对外全面开放,这也意味着TPU的商业化正在加速。

“我们对此感到非常兴奋,因为许多研究人员和工程师在进行机器学习时都遇见了计算力不足的问题,而我们认为这(即 Cloud TPU)将是一个很好的解决方案。举例来说,我们一个 Cloud TPU 设备可以在 24 小时内将运行在 resnet-50 上的模型的识别精度训练到 75%。”Jeff Dean 在推特上兴奋地表示。

TPU是谷歌为机器学习而设计的人工智能定制芯片。将TPU开放,对于选择在谷歌云平台上运行机器学习模型的客户来说,可谓好事一桩。但谷歌这次开放的TPU数量有限,而且按时收费,每小时成本为6.50美元。

TPU是谷歌为机器学习而设计的人工智能定制芯片,是一种ASIC(专用集成电路)。是谷歌为机器学习而设计的人工智能定制芯片,第一代TPU于2016年低调推出,广泛应用在AlphaGo、搜索、翻译、相册等背后的机器学习模型中。在AlphaGo战胜李世石的系列赛中,TPU能让AlphaGo“思考”更快,“想”到更多棋招、更好地预判局势。

第二代TPU是在2017年5月18日的Google I/O 大会上推出,也称为云TPU。云TPU对推理和训练都进行了优化,每个 Cloud TPU 包含 4 个定制化的 ASIC,每个 Cloud TPU 的计算能力达到每秒 180 万亿次浮点运算(180 teraflops),并提供有 64GB 的高带宽内存。另外,这些电路卡即可以单独使用,也可以通过超高速专用网络连接起来,形成一个多层次的机器学习超级计算器,谷歌将之称为“TPU pod”。谷歌预计今年晚些时候,将会开始供应这种更大的超级计算器,并表示训练的时间-精度比将得到显着提升。

TPU专用于人工智能和机器学习,可为谷歌带来两大好处:

首先,利用自主研发的芯片,谷歌可以在核心的计算基础设施方面更便宜、更有效地减少对英特尔、英伟达等芯片制造商的依赖。拥有自己的硬件使谷歌能够更快地进行实验。

其次,新的TPU也为谷歌的云计算业务带来额外收入,现在,谷歌云平台(GCP)和谷歌的业务应用程序GSuite每季度可超过10亿美元收入。

谷歌目前允许公司租用单个TPU板卡,今年晚些时候,将允许企业租用多个板卡,并连接成名为TPU pod的超级计算机网络。后面谷歌会开源更多的 ML 模型。

芯片提供的是人工智能三要素中的计算力,如今TPU的全面开放,可为中小AI公司在2018年的商业化应用落地提供硬件上的强大支撑。但也有业内人士评论称“TPU只能通过云获取是一大障碍,英伟达在硬件方面还是碾压谷歌”,并且认为“TPU对固定算法还是有要求,目前应用范围最广还是GPU。”

Previous:2018年1月份国内手机出货量同比下降16.6%

Online messageinquiry

谷歌宣布推出Arm架构AI芯片Axion

- Week of hot material

- Material in short supply seckilling

| model | brand | Quote |

|---|---|---|

| BD71847AMWV-E2 | ROHM Semiconductor | |

| MC33074DR2G | onsemi | |

| TL431ACLPR | Texas Instruments | |

| RB751G-40T2R | ROHM Semiconductor | |

| CDZVT2R20B | ROHM Semiconductor |

| model | brand | To snap up |

|---|---|---|

| STM32F429IGT6 | STMicroelectronics | |

| BP3621 | ROHM Semiconductor | |

| IPZ40N04S5L4R8ATMA1 | Infineon Technologies | |

| BU33JA2MNVX-CTL | ROHM Semiconductor | |

| ESR03EZPJ151 | ROHM Semiconductor | |

| TPS63050YFFR | Texas Instruments |

Qr code of ameya360 official account

Identify TWO-DIMENSIONAL code, you can pay attention to

Please enter the verification code in the image below: