- Ameya360 Component Supply Platform >

- Trade news >

- 英伟达针对AI市场推出双GPU产品 H100 NVL

英伟达针对AI市场推出双GPU产品 H100 NVL

Release time:2023-03-23

author:AMEYA360

source:网络

reading:3329

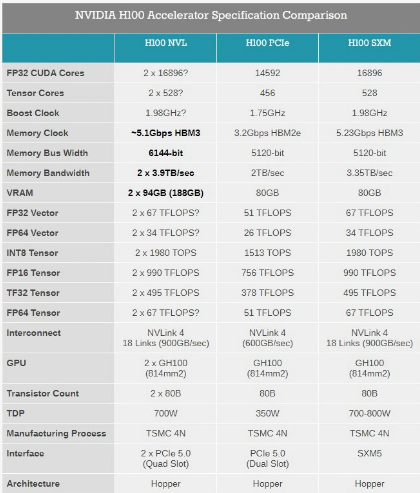

据最新报道,英伟达在 GTC Spring 2023 主题演讲中,针对不断增长的 AI 市场,推出了全新的双 GPU 产品 H100 NVL。H100 NVL 在顶部配备了 3 个 NVLink 连接器,使用两个相邻的 PCIe 显卡插槽。

英伟达表示在运行大型语言模型(LLM)时,常规显卡的显存无法驾驭庞大的数据流。因此本次推出的 H100 NVL 最高可以提供 188GB HBM3 显存,单卡显存容量 94GB。

的功耗略高于 H100 PCIe,每个 GPU 为 350-400 瓦(可配置),增加了 50W。总性能实际上是 H100 SXM 的两倍:FP64 为 134 teraflops,TF32 为 1979 teraflops,FP8 为 7916 teraflops,INT8 为 7916 teraops。

内存带宽也比 H100 PCIe 高很多,每个 GPU 为 3.9 TB / s,总和为 7.8 TB / s(H100 PCIe 为 2 TB / s,H100 SXM 为 3.35 TB / s)。

("Note: The information presented in this article is gathered from the internet and is provided as a reference for educational

purposes. It does not signify the endorsement or standpoint of our website. If you find any content that violates copyright or

intellectual property rights, please inform us for prompt removal.")

Online messageinquiry

reading

行业新闻

英伟达发布新GPU!

2025-09-10 14:33

reading:687

行业新闻

英伟达暂停生产H20芯片

2025-08-22 10:45

reading:1641

Popular categories

- Week of hot material

- Material in short supply seckilling

| model | brand | Quote |

|---|---|---|

| RB751G-40T2R | ROHM Semiconductor | |

| MC33074DR2G | onsemi | |

| BD71847AMWV-E2 | ROHM Semiconductor | |

| TL431ACLPR | Texas Instruments | |

| CDZVT2R20B | ROHM Semiconductor |

| model | brand | To snap up |

|---|---|---|

| ESR03EZPJ151 | ROHM Semiconductor | |

| IPZ40N04S5L4R8ATMA1 | Infineon Technologies | |

| BU33JA2MNVX-CTL | ROHM Semiconductor | |

| BP3621 | ROHM Semiconductor | |

| STM32F429IGT6 | STMicroelectronics | |

| TPS63050YFFR | Texas Instruments |

Hot labels

ROHM

IC

Averlogic

Intel

Samsung

IoT

AI

Sensor

Chip

Information leaderboard

About us

Qr code of ameya360 official account

Identify TWO-DIMENSIONAL code, you can pay attention to

AMEYA360 mall (www.ameya360.com) was launched in 2011. Now there

are more than 3,500 high-quality suppliers, including 6 million product model data,

and more than 1 million component stocks for purchase. Products cover MCU+ memory +

power chip +IGBT+MOS tube + op amp + RF Bluetooth + sensor + resistor capacitance

inductor + connector and other fields. main business of platform covers spot sales

of electronic components, BOM distribution and product supporting materials,

providing one-stop purchasing and sales services for our customers.

Please enter the verification code in the image below: